半个月前,AMD的苏姿丰发布了新款大语言模型GPU MI300X,据说比Nvidia的H100更小更快。

说起来,美国朋友追求又小又快已经很多年了。

最近浙江人民出版社的朋友寄给我一本《芯片战争》,说你看看。我说我看过英文版,总是打开又合上,合上又打开。他说你是看不懂英文吗?看不起谁呢,my English is fine thank you, and you?

中文版的《芯片战争》翻译的不错,作者用一个个芯片发展史上的历史故事告诉读者,为什么靠砸钱和堆人搞不出芯片产业。

因为整个行业的分工极为细密,背后是一个极其复杂的商业生态系统,这个系统不可能源于任何政府扶持,也不可能有任何国家做到全产业链独立自主,它依靠的是企业家们像生物演化一样的:

自行冒险和优胜劣汰。

中国人是不缺优胜劣汰的,缺不缺冒险精神,网上一直争论不休。要说不缺吧,考公的人是越来越多,要说缺吧,ChatGPT大火之后的短短几个月内,国内光是上市公司就有9个老板说自己要搞大模型后随即离婚的,导致原本就不富裕的存量夫妻数量因此雪上加霜。

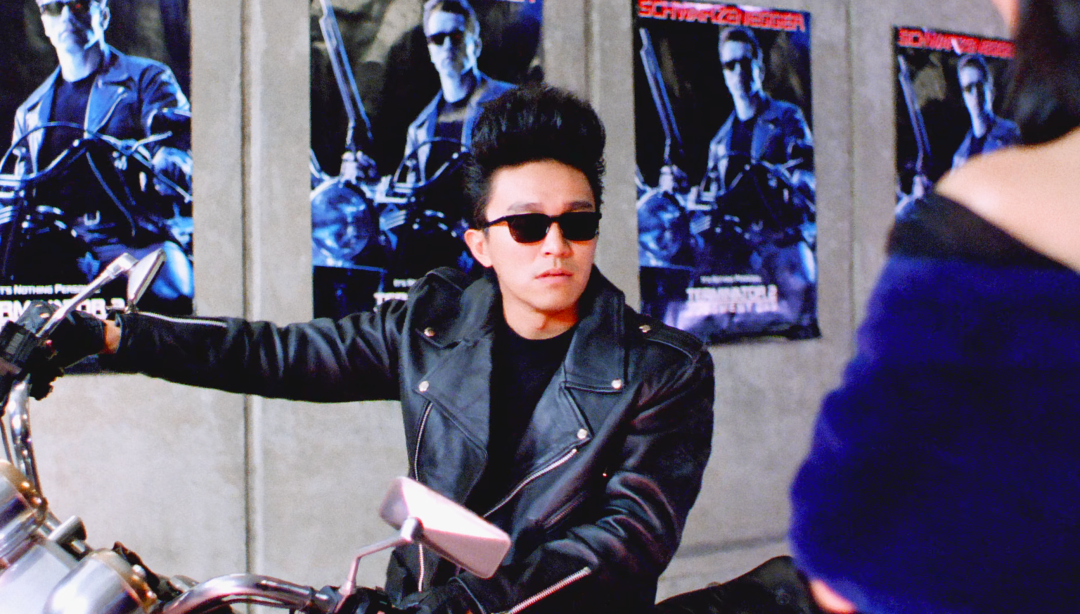

最重要的是,你看AI芯片最核心的三个大拿黄仁勋、苏姿丰和张忠谋都是华裔。再具体一点,他们都是胡建裔。

昨天,字节跳动旗下的火山引擎开了个大模型发布会。国内别的大模型起名都文文静静的,什么文心、混元、通义,唯独火山引擎给自己的大模型平台起了个去哪个国家都不要签证的名字:

方舟。

搞AI,果真还是要靠纯血胡建朋友。

自从几万年前人类征服了蓝色星球之后,仰望星空后的好奇促使大家做了一个违反祖宗的决定——暴露自己,不顾黑暗森林法则。

至于为什么这么做,千百年来从哲学家到科学家做过很多解释。蚝腩觉得,主要是因为太过孤独。

为了对抗集体孤独感,除了寻找地球之外的智慧生命,还有就是试图给自己之外的东西注入神性。

从远古神话里出现的黄金机器人到雪莱的《科学怪人》,从亚里士多德的三段论逻辑到微积分发明人莱布尼兹试图设计一种普适性语言,经历了几千年的探索,即便在计算机技术不断进步后,人类还经历了无数次挫败。

具体到怎么让机器人和人自然对话甚至完成交办的任务这方面,直到2017年,谷歌的一篇论文《Attention is all you need》,才算是真正打开了局面。

这篇论文看起来很简洁,主要就是讲Transformer(翻译器)是怎么工作的,这个Transformer就是ChatGPT里的T。

有了可以验证的理论,大家就把大语言模型的训练实现基本简化为了两个要素:

语料和算力。

简单点来说,先要有足够多的文字内容,然后要规划学习方法,比如自己学习,工程师监督学习和用户反馈后的强化学习。看起来和人类学习过程差不多,但机器学习是可以开挂的,想让它加快学习过程,就要上算力,大幅提升训练速度。

比如为了训练ChatGPT-3,微软给OpenAI配了10000张A100显卡,单次训练成本上千万美元,这个我们中国人理解起来一点也不难。想让孩子上清北吗?从小学开始就要择校,吃好的用好的还要报各种班。

去年底ChatGPT大火之前,连搞AI的人自己都在怀疑自己。阿里云在去年降价了6次,GPU租用价格下降了两成,腾讯也直接砍掉了对NVIDIA GPU的采购单。

然后,ChatGPT火了,大家纷纷宣布我也行,我也能上。最夸张的是很善于做全家桶的周总,他说:

比尔·盖茨都没我看得准。

20多年前,从亚马逊诞生到阿里巴巴诞生,大概用了5年;从有ICQ到腾讯有OICQ,大概用了两年;从谷歌诞生到百度诞生,大概用了15个月。

从ChatGPT大火到比尔·盖茨都没我看得准用了多久呢?一个季度。

大家树新风的样子,像极了在大集上喝早酒的山东朋友。一开始,镜头前的本地大哥都是配着羊汤喝瓶啤酒或者二两白酒。后来,出现了一碗羊汤配一斤散篓子的大妈和两斤散篓子的大爷。到最后,有个大哥抱了一桶十斤装的白酒告诉拍摄者:

这是我一天的量。

只有少数还没上头的。媒体问字节副总裁杨震原有没有开发大模型,杨震原会说我们在学习。被问到大模型进展怎么样,他说很初级、不成熟。

腾讯也是一贯的务实风格。马化腾说对于工业革命来讲,早一个月把电灯泡拿出来,在长的时间跨度上来看是不那么重要的。关键还是要把底层的算法、算力和数据扎扎实实做好,而且更关键的是场景落地,目前我们还在做一些思考。我感觉现在有很多公司太急了,感觉是为了提振股价。

你直接报周总身份证号得了。

今天和一位爱摊煎饼的朋友聊天,问他房地产行业的朋友会不会搞大语言模型。他说放在以前肯定会,那会儿大家连买煎饼都是要双肠双蛋,还得多刷甜面酱。

这估计代表了大部分加入大语言模型潮流企业的心态,一开始大家都想自己做,其中有很多原因,除了赶时髦外,比如模型方担心私有化部署技术泄露,企业担心自己多年积累的数据泄密。

网络安全公司Cyberhaven做过调查,至少有 4%的员工将企业敏感数据输入 ChatGPT,敏感数据占输入内容的比例高达 11%。2023 年初,三星公司在使用 ChatGPT不到20天时,就发现其半导体设备相关机密数据被泄露,并连续发生3起类似事故。

那怎么办,难道各行各业都自己做大模型?倒也不是不行。

火山引擎的朋友给蚝腩科普了一下,5年前,一家企业要搞机器学习产品,是个很复杂的系统工程。现在你从北大招个应届生,给他两天时间,他就可以完整地把一些图像识别、 pipeline能整体搭建出来,不需要给他搞低代码。而且有些行业的客户比如自动驾驶,在很多深度领域比很多大模型开发商做得更好。

但什么都自己做会面临高额的硬件成本和训练成本。很多行业并不需要非常通用的、巨大的基座模型。比如银行客服不需要模型会写代码,房产中介也不需要模型会做数学题。如果盲目买一堆GPU回来自己搞大模型,收益肯定是小于成本的。

所以在方舟的发布会上,火山引擎总裁谭待强调了大模型要用起来,不能光看参数大、效果强,使用成本一定要降下来。

翻译成大白话就是,大家没必要啥都自己从0到1,各自发挥长处就好。比如芯片制造业,从设计到生产全都自己做的英特尔和三星,现在被协同作战的AMD、高通、NVIDIA、台积电按着头打。

这里面的道理,讲得最清楚的还要说是胡建裔的黄仁勋。他反复劝说美国政商两届不要搞芯片禁令,不要逼中国搞出软硬一体的独立系统。

做生意嘛,大家要都有得赚才长久。

在ChatGPT去年底火起来之前,为什么只有字节在逆势囤GPU,其实是有逻辑脉络的,而且他们的思考比较超前。

2020年,抖音推荐广告系统开始技术架构的升级,基于Transformer实现大规模的模型训练。推荐广告核心能力必须把模型做得很深,才可以对很多事物之间的关联有好的理解。无论是技术上、还是算力上,火山引擎都做了比较充分的准备。

别人开发布会说的都是我这个大模型比ChatGPT好在哪里,火山引擎的发布会上,一直强调的却是性价比,讲得是模型精调、算力调度,还有和NVIDIA一起共同合作的 GPU 推理库 ByteTransformer 在 IEEE 国际并行和分布式处理大会(IPDPS 2023)上获得最佳论文奖等等。

10年前,各大新闻平台的销售来蚝腩办公室讲的都是用户量,浏览量和投放折扣。只有今日头条的销售不一样,他们会耐心地给你讲什么是算法,一个人在头条为什么总能看到自己感兴趣的内容,这对你们公司有什么用。

10年过去了,除了A股,大概没什么变化的也只有他们了。

三天前,锂电池的发明者古迪纳夫去世,享年100岁。3年前,他以97岁高龄成为了诺贝尔奖历史上最年长的得主。

在看讣告时,蚝腩读到了他的一句话——我们有些人就像是乌龟,走得慢,一路挣扎,到了而立之年还找不到出路。

但乌龟知道,他必须走下去。

华人特别喜欢歌颂速度。苏姿丰30岁时凭借设计铜电路替代铝电路成为了IBM CEO的技术助理;黄仁勋30岁时和两位工程师一起创立了NVIDIA。

底层文化里,华人是不可能称赞乌龟的,大家称赞的都是高大全快。

相反,德日甚至瑞典的一些企业可能产品看起来一点不起眼,一个轴承,一颗螺丝甚至一个锉刀,一捆绝缘线能钻研一辈子,但全世界工业企业都离不开他们。

当经济高速发展时,他们把自己投入大生态顺势而为,当经济进入下行周期的时候,这些企业靠着专精能力,活得也很舒服。

这种跨越周期的能力,大概就是古迪纳夫说的“乌龟”吧。

现在习惯了快的我们也慢下来了,蚝腩觉得大伙面对大模型这种时代巨浪还是要有些定力,如果搞不起军备竞赛,雇不起大量的北大应届生,那还是先冷静冷静,想想大模型对自己有啥用,算清楚ROI。如果用大模型比雇人干活还要贵,还不如多招些人,也是为就业做贡献了。

这样对很多企业来说是最划算和安全的,风浪越大鱼越贵是没错,但首先要保证自己一直在船上。

来源:兽楼处 微信号:ishoulc

微信扫一扫打赏

微信扫一扫打赏 支付宝扫一扫打赏

支付宝扫一扫打赏